Brána AI: Propojte a bezpečně spravujte všechny své modely LLM

Vyzkoušejte naše pluginy AI

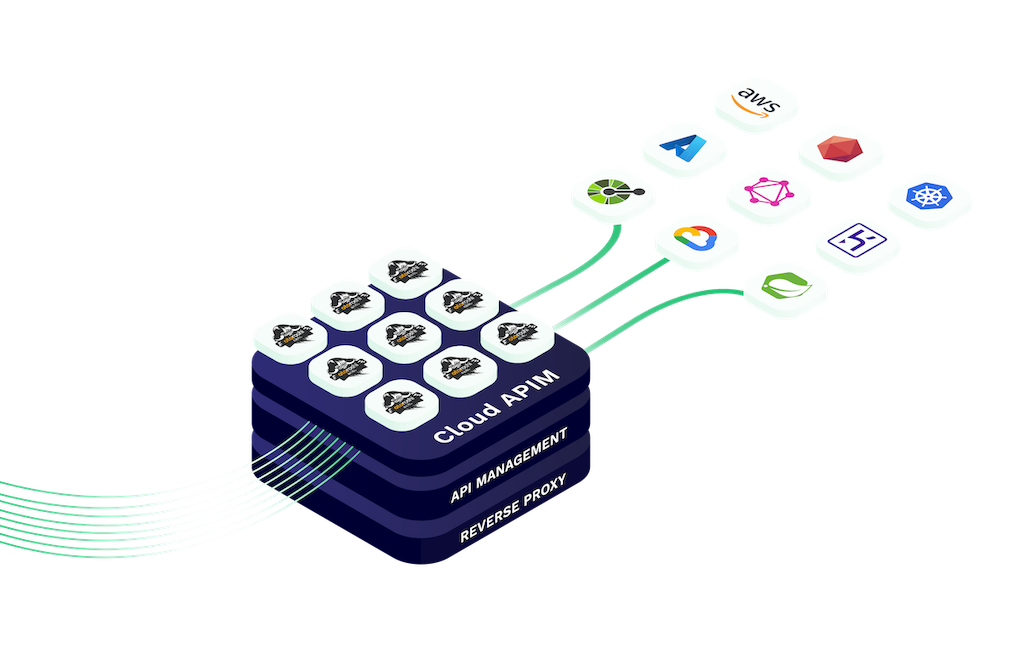

Integrace AI do vašich bran API umožňuje bezproblémový přístup k modelům strojového učení a službám AI.

Naše brána AI bezpečně spravuje požadavky, zpracovává data a efektivně poskytuje poznatky s využitím AI.

Ať už začleňujete prediktivní analýzu, zpracování přirozeného jazyka nebo jiné funkce AI, brány AI Cloud APIM usnadňují, škálují a zabezpečují integraci.

AI Gateway od Cloud APIM umožňuje vývojářům snadno se propojit s rozsáhlými jazykovými modely (LLM) prostřednictvím jednotného rozhraní API kompatibilního s OpenAI. Ať už používáte OpenAI, open-source modely nebo hybridní nasazení, naše brána zajišťuje konzistentní, bezpečný a škálovatelný přístup.

Tato flexibilní architektura umožňuje rychlé nasazení, integraci napříč poskytovateli a podporu více prostředí. Je navržena pro podniky i startupy, odstraňuje závislost na dodavateli a umožňuje směrovat požadavky na základě výkonu, nákladů nebo zeměpisné polohy.

Díky nativní podpoře v Otoroshi a plným funkcím sledovatelnosti je AI Gateway dokonalým základem pro vaše API řízené umělou inteligencí.

aigateway.section1.desc4

Use our all-in-one interface : Simplify interactions and minimize integration hassles

10+ LLM providers supported right now, a lot more coming. Use OpenAI, Azure OpenAI, Ollama, Mistral, Anthropic, Cohere, Gemini, Groq, Huggingface and OVH AI Endpoints

Speed up repeated queries, enhance response times, and reduce costs.

Ensure optimal performance by distributing workloads across multiple providers

Manage LLM tokens quotas per consumer and optimise costs

Every LLM request is audited with details about the consumer, the LLM provider and usage. All those audit events are exportable using multiple methods for further reporting

Připojte se k předním vývojářům a podnikům, které používají Cloud APIM k integraci AI do svých platforem.

Ať už vytváříte inteligentní pracovní postupy nebo škálovatelná chatovací rozhraní, naše AI Gateway je zajistí bezpečným, cenově efektivním a bleskově rychlým řešením.

Začněte svou cestu k chytřejším API a lepším uživatelským zážitkům ještě dnes.

AI Gateway od Cloud APIM, poháněná rozšířením Otoroshi LLM, vám poskytuje plný přehled a kontrolu nad náklady na každý velký požadavek na jazykový model.

Snadno sledujte využití API, generujte podrobné zprávy o nákladech pro každý model a dolaďte své využití, abyste snížili plýtvání a maximalizovali efektivitu u všech poskytovatelů LLM.

Sledování nákladů je ve výchozím nastavení v rozšíření Otoroshi LLM povoleno, což usnadňuje dodržování rozpočtu a zároveň bezpečné a inteligentní škálování infrastruktury AI.

An AI Gateway is similar to an API Gateway but designed specifically for handling AI or machine learning requests. It manages, routes, and secures AI-based interactions such as LLM calls, ensuring reliable and scalable integration of artificial intelligence in applications.

Cloud APIM AI Plugins are built-in and require no extra setup. You can use them in both our Serverless and Otoroshi Managed environments to quickly integrate AI features into your APIs.

Our AI Gateway supports OpenAI, Azure OpenAI, Ollama, Mistral, Anthropic, Cohere, Gemini, Groq, Huggingface, OVH AI Endpoints, and more. Over 10+ LLM providers are currently supported and new ones are added frequently.

Yes, semantic cache is available in both Otoroshi Managed and Serverless products. It improves response speed for repeated or similar queries, reduces latency, and cuts down on LLM processing costs.

Yes. Our AI Gateway, through the Otoroshi LLM Extension, provides detailed cost tracking for every LLM request. You can generate per-model reports and monitor usage to optimize your AI budget effectively.

Yes, our AI Gateway is fully OpenAI-compatible. You can connect to OpenAI’s API directly or use it alongside other LLM providers in a unified interface with routing, security, and observability.

Absolutely. With our multi-model routing, you can send requests to different LLMs based on rules like cost, performance, or context, making your AI architecture more flexible and optimized.

Semantic caching identifies and stores similar LLM queries to avoid repeated calls. This dramatically reduces the number of expensive model invocations, saving on token usage and improving response times.

Yes. With our AI Gateway, you can define token quotas, request limits, or model usage caps per route, API key, or user — helping you enforce budget limits and optimize LLM costs across teams.

AI Gateways let you route traffic between models based on cost, speed, or purpose. For example, you can use a cheaper open-source model for basic tasks and reserve premium LLMs like GPT-4 for high-value queries.

Yes. The Otoroshi LLM Extension includes detailed analytics. You can view cost per request, generate usage and spend reports by model, and export them for billing or optimization purposes.

With our AI Gateway, you can connect to multiple LLM providers using a unified OpenAI-compatible API. It simplifies model switching, load balancing, and routing through a single secured entry point.