AI Gateway : Conecte y gestione de forma segura todos sus modelos LLM

Pruebe nuestros plugins de IA

La integración de la IA en sus API Gateways permite un acceso sin fisuras a los modelos de aprendizaje automático y a los servicios de IA.

Nuestra puerta de enlace de IA gestiona de forma segura las solicitudes, procesa los datos y proporciona información impulsada por IA de forma eficiente.

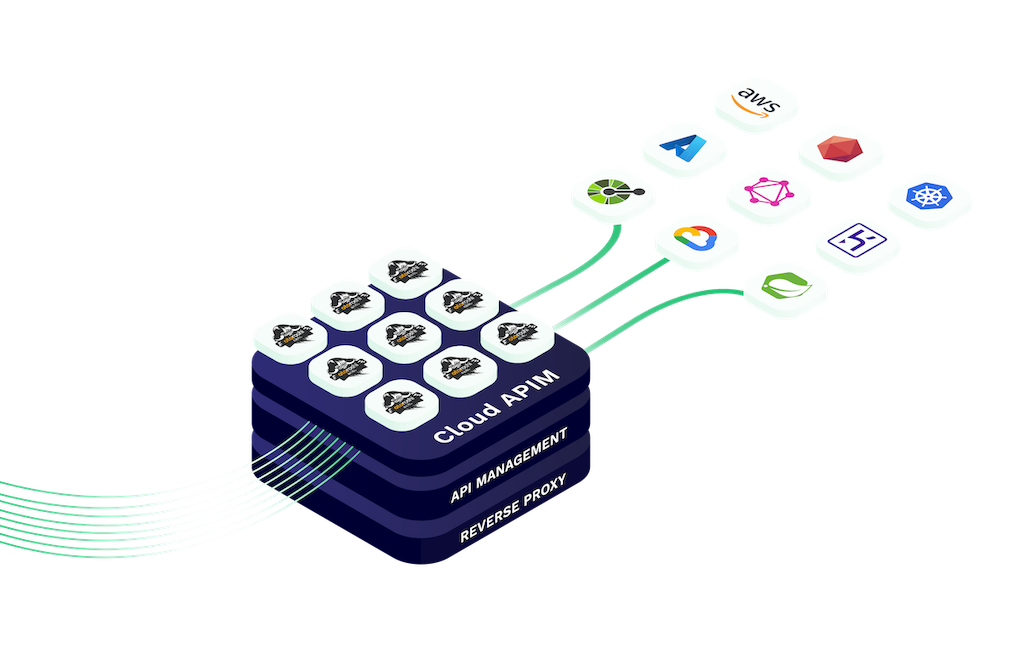

Tanto si está incorporando análisis predictivo, procesamiento de lenguaje natural u otras funciones de IA, las puertas de enlace de IA de Cloud APIM hacen que la integración sea fácil, escalable y segura.

La puerta de enlace de IA de Cloud APIM permite a los desarrolladores conectarse fácilmente con grandes modelos de lenguaje (LLM) a través de una interfaz API unificada compatible con OpenAI.Tanto si utiliza OpenAI, modelos de código abierto o implementaciones híbridas, nuestra puerta de enlace garantiza un acceso coherente, seguro y escalable.

Esta arquitectura flexible permite una rápida implementación, integración entre proveedores y compatibilidad con varios entornos.Diseñado tanto para empresas como para startups, elimina la dependencia del proveedor y le permite enrutar las solicitudes en función del rendimiento, el coste o la ubicación geográfica.

Con compatibilidad nativa con Otoroshi y funciones completas de observabilidad, el AI Gateway es la base definitiva para sus API basadas en IA.

aigateway.section1.desc4

Use our all-in-one interface : Simplify interactions and minimize integration hassles

10+ LLM providers supported right now, a lot more coming. Use OpenAI, Azure OpenAI, Ollama, Mistral, Anthropic, Cohere, Gemini, Groq, Huggingface and OVH AI Endpoints

Speed up repeated queries, enhance response times, and reduce costs.

Ensure optimal performance by distributing workloads across multiple providers

Manage LLM tokens quotas per consumer and optimise costs

Every LLM request is audited with details about the consumer, the LLM provider and usage. All those audit events are exportable using multiple methods for further reporting

Únase a los principales desarrolladores y empresas que utilizan Cloud APIM para integrar la IA en sus plataformas.

Tanto si está creando flujos de trabajo inteligentes como interfaces de chat escalables, nuestra AI Gateway lo hace seguro, rentable y rapidísimo.

Comience hoy mismo su viaje hacia APIs más inteligentes y mejores experiencias de usuario.

AI Gateway de Cloud APIM, impulsado por la extensión LLM de Otoroshi, le ofrece visibilidad y control totales sobre el coste de cada solicitud de modelo lingüístico de gran tamaño.

Supervise fácilmente el uso de la API, genere informes de costes detallados por modelo y ajuste su uso para reducir los residuos y maximizar la eficiencia en todos los proveedores de LLM.

El seguimiento de costes está activado por defecto en la Extensión LLM de Otoroshi, lo que simplifica el mantenimiento del presupuesto mientras escala su infraestructura de IA de forma segura e inteligente.

An AI Gateway is similar to an API Gateway but designed specifically for handling AI or machine learning requests. It manages, routes, and secures AI-based interactions such as LLM calls, ensuring reliable and scalable integration of artificial intelligence in applications.

Cloud APIM AI Plugins are built-in and require no extra setup. You can use them in both our Serverless and Otoroshi Managed environments to quickly integrate AI features into your APIs.

Our AI Gateway supports OpenAI, Azure OpenAI, Ollama, Mistral, Anthropic, Cohere, Gemini, Groq, Huggingface, OVH AI Endpoints, and more. Over 10+ LLM providers are currently supported and new ones are added frequently.

Yes, semantic cache is available in both Otoroshi Managed and Serverless products. It improves response speed for repeated or similar queries, reduces latency, and cuts down on LLM processing costs.

Yes. Our AI Gateway, through the Otoroshi LLM Extension, provides detailed cost tracking for every LLM request. You can generate per-model reports and monitor usage to optimize your AI budget effectively.

Yes, our AI Gateway is fully OpenAI-compatible. You can connect to OpenAI’s API directly or use it alongside other LLM providers in a unified interface with routing, security, and observability.

Absolutely. With our multi-model routing, you can send requests to different LLMs based on rules like cost, performance, or context, making your AI architecture more flexible and optimized.

Semantic caching identifies and stores similar LLM queries to avoid repeated calls. This dramatically reduces the number of expensive model invocations, saving on token usage and improving response times.

Yes. With our AI Gateway, you can define token quotas, request limits, or model usage caps per route, API key, or user — helping you enforce budget limits and optimize LLM costs across teams.

AI Gateways let you route traffic between models based on cost, speed, or purpose. For example, you can use a cheaper open-source model for basic tasks and reserve premium LLMs like GPT-4 for high-value queries.

Yes. The Otoroshi LLM Extension includes detailed analytics. You can view cost per request, generate usage and spend reports by model, and export them for billing or optimization purposes.

With our AI Gateway, you can connect to multiple LLM providers using a unified OpenAI-compatible API. It simplifies model switching, load balancing, and routing through a single secured entry point.